AI 推理躍升與智能詛咒

從 DeepSeek 到推理型 AI 的重大突破,探討 AI 從生成到推理的躍升歷程。深入分析AGI 發展對社會的影響,以及我們該如何應對即將到來的智能革命。

“Show me the incentive, and I’ll show you the outcome.” – Charlie Munger

❏ 引言

嘿,大家年假都過的好嗎? 有好好地陪伴愛你&你愛的人 或是 進行一場內心的年度整理 嗎?

過年期間,我追了一步 NFLX 動畫片「藍色監獄」:

講述日本為了將足球實力進一步提升至世界第一,需要培養出一位違反民族性,極度自私的攻擊型前鋒。於是,像韓劇魷魚遊戲那樣,給全國有潛力的高中生們發邀請函,全部集中到一個地方進行嚴苛的訓練和淘汰賽。通過層層淘汰後最終留下來的勝者,就可以直接加入國家隊!動畫劇情緊湊,精心設計的賽制鮮明地勾勒出不同角色的個性,看的熱血沸騰。

~

最近 AI 界的大新聞無疑就是 DeepSeek 超凡的表現,極低的訓練成本、比肩大廠的 benchmark 跑分。在除夕那天,甚至讓美股大跳水。

為什麼 DeepSeek 會帶來這麼大的震撼?

推理型模型和前代模型又有什麼區別?

是怎麼樣的訓練方法讓模型學會了推理?

當模型學會推理之後,我們不再需要思維鏈 (Chain of Thought) 來引導模型思考,模型從副駕 (Copilot) 變成主駕,那人類還剩下什麼價值?

鋪天蓋地的新聞,心裡揣著諸多疑惑,就在我一邊看著「藍色監獄」的同時,答案似乎以某種隱喻的方式被慢慢揭開。

藍色監獄的主持人 繪心甚八 這麼說:

所謂的「覺醒」,是透過思考與經驗累積後引發的「拼圖」,

在不斷的失敗與反覆測試中,為了求勝而面對自身極限。

此時那些指引成功之路的散亂碎片將正確的拼合,使「自我」開花的結果。

換句話說,所謂的「覺醒」… 就是瞭解自己的瞬間。

我不禁想,自 ChatGPT 問世以來,模型能力的演進:

預測下一個 token → 生成一個段落 → 用思維鏈、RAG 增強模型結構性思維 → 模性能夠自己策略規劃,並拆解成一步步的行動 → ...就像主角被丟到藍色監獄當中,不斷快速迭代升級 (Reinforcement learning) 的感覺!

~

📚 文章目錄

1. 從「生成」到「推理」的躍升

a. 強化學習 Reinforcement Learning (RL)

b. 提示工程的新範式:從「如何思考」到「要什麼結果」

2. 推理型應用程式

3. 智能詛咒

a. AGI 更像是一種「資源」,而非「工具」

b. 仰賴資源的國家

c. 少數權力者的動機

d. AGI 帶來的真正威脅《非正式寫作》著墨琢磨 技術趨勢、溝通領導、概念理解 與 生活實踐。

每週派送,如果您還沒有訂閱,請在這裡訂閱,加入 500+ 位每週讀者的行列:

🔍 工人智慧猜你也喜歡

❏ 從「生成」到「推理」的躍升

前期《解構AI Agent: 人工智慧的關鍵突破?》中我曾提到 AI Agent 關注的三個自動:感知、規劃和行動,其中又以「規劃」為最核心的關鍵。

在推理型 LLM (OpenAI o1, Gemini 2.0 Flash Thinking, DeepSeek R1, etc…) 問世以前,模型主要靠著 橫跨上下文的理解 和 從大量訓練資料中習得的模式 兩種能力,來回答我們的提問。

隨著訓練資料與參數規模的持續擴增 (GTP3 → GPT3.5 → GPT4),在清晰的命題與足夠上下文的情境當中,模型的表現越來越好。

但是當問題的 複雜度/抽象程度 越來越高的時候,單靠這兩種能力就顯得力不從心。複雜度/抽象程度的提高,意味著這個問題可能需要 跨領域的知識結合 或是 不確定路徑的探索,這兩者會讓模型 檢索已習得模式 (選擇) 和 傳遞完整上下文 (彙整) 的難度指數級上升。

因此,才有所謂 Chain of Thought (CoT) 的提示詞技巧:由人類在提示詞裡面演示/引導任務分解和成果匯總,讓模型遵循拆解出來的步驟,一步步完成任務。

隨著推理型 LLM 的問世,「任務拆解」和「反思」不再需要人類的介入,而是直接內建在模型當中,這是怎麼辦到的?

~

✔ 強化學習 Reinforcement Learning (RL)

傳統的機器學習 (Supervised Learning),我們提供大量的標記資料 (同時提供 input 和 answer) 讓模型習得其中的關聯。

但是,有些任務 人類自己也無法(很難)確定怎樣才是對(好)的 (比如圍棋的下一手應該落子在何處、如何將抽象的大目標拆解成一個個小步驟、等等…),或是 標記資料難以取得,這類問題就蠻適合用 強化學習 (RL) 來嘗試。

RL 不依賴標記資料,而是透過不斷的嘗試,從環境中取得反饋,持續迭代更新自己以獲得最大獎賞。

像是之前的 AlphaGo 擊敗世界棋王,AlphaGo 透過和自己對奕,在極短的時間內,累積了超越整個圍棋歷史有紀錄的比賽場數,並從這千萬場的勝敗當中,強化那些最終導致勝局的策略、避免那些最終導致敗局的失手。

是怎麼樣的訓練方法讓模型學會了推理?

既然匠心獨具的 CoT 提示技巧可遇不可求,那麼,何不訓練模型自己產生一組最佳的 CoT 呢?

就像人類在回答一個難題之前可能會思考很長時間一樣,o1 在解決問題時也會使用一連串的思考。透過「強化學習」,o1 學會磨練它的「思維鏈」,並改善它所使用的策略。

它學會認知和糾正錯誤。它學會將棘手的步驟分解成更簡單的步驟。

當目前的方法不奏效時,它學會嘗試不同的方法。這個過程大幅提升了模型的推理能力[1]

將強化學習 (RL) 應用在 思維鏈 (CoT) 上,是不是很像 繪心甚八 所謂「覺醒」的前提呢:

所謂的「覺醒」,是透過思考與經驗累積後引發的「拼圖」(CoT),

在不斷的失敗與反覆測試中 (RL),為了求勝而面對自身極限 (Training)。

當 ”思考” 與 ”經驗” 正確的拼合,就是更深刻了解自己的瞬間,就是模型展現覺醒,展現出更進階推理能力的時刻!

~

✔ 提示工程的新範式:從「如何思考」到「要什麼結果」

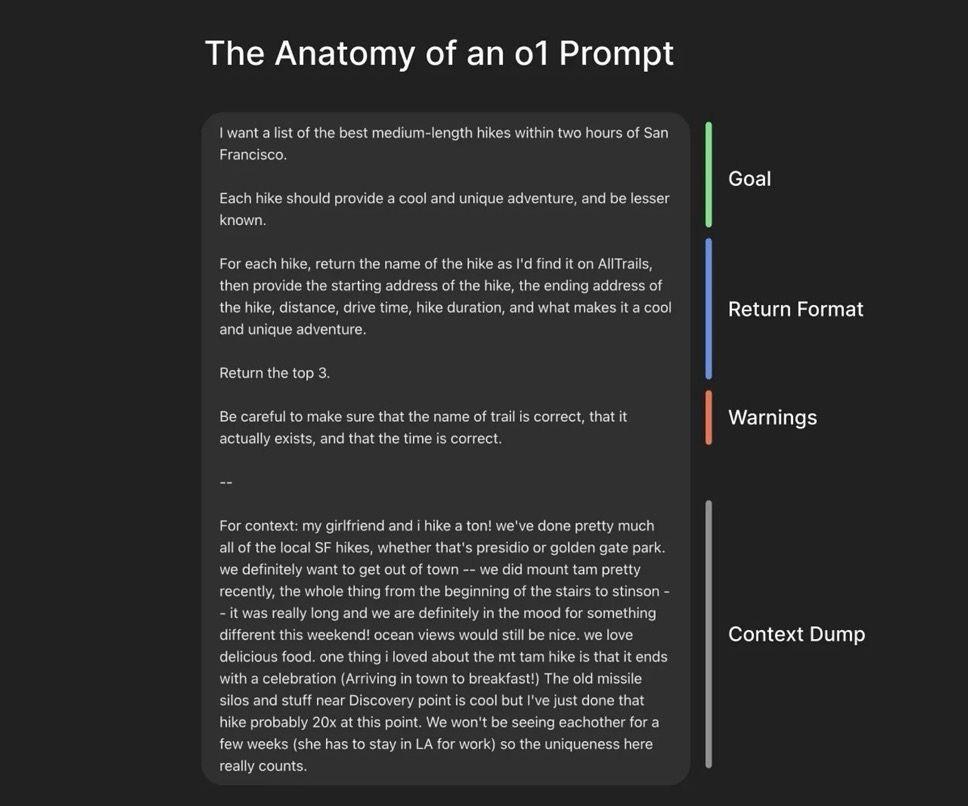

既然推理型 LLM 已經內建「任務拆解」和「反思」的能力,我們與之互動的方式也應該跟著改變。如果還是照以前的提示詞作法,落落長的耳提面命模型應該如何如何,恐怕會造成反效果 (模型的思考能力反而被限制了)。

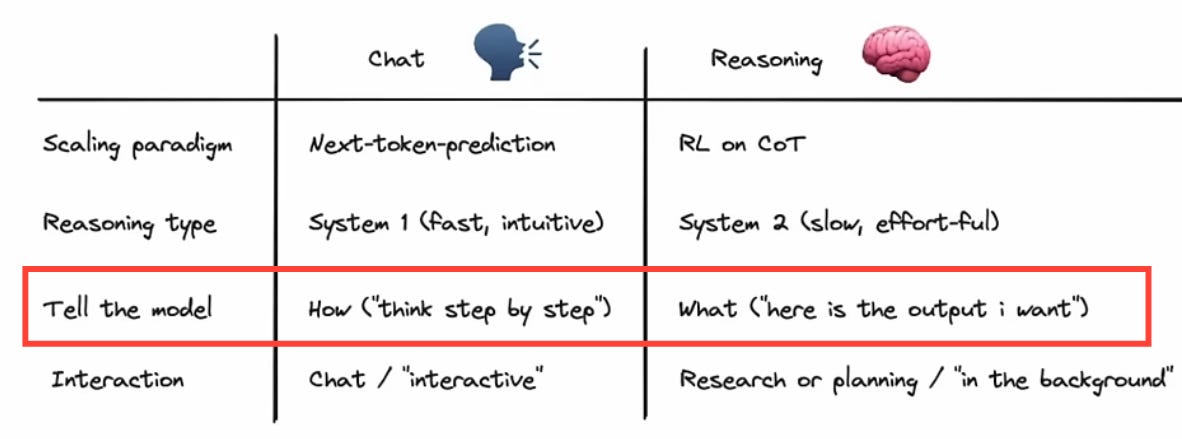

套用《快思慢想》中描述認知運做的兩個系統來區分 聊天模型 與 推理模型:

聊天模型就像系統一,對於邊界明確的問題或任務,調用直覺來快速應對。既然是調用直覺,那麼任務的粒度 以及 提示詞當中是否具備足夠的線索就相當關鍵。在系統一的模式下,我們主要和模型溝通的是 “How” (清楚傳達我們希望模型如何完成任務)。

推理模型就像系統二,對於需要邏輯推演或深入分析的任務,調用更多的認知資源,集中注意力慢慢思考。在系統二的模式下,我們主要和模型溝通的是 “What” (清楚傳達最終目標是什麼,我們期望的結果是什麼樣貌),讓出空間給模型發揮他的推理能力。

有點像是程式語言的不同範式:Imperative 命令式 vs. Declarative 宣告式。Imperative 程式語言像是 Java, Python 主要描述如何作,Declarative 程式語言像是 SQL, HCL (HashiCorp Configuration Language) 主要描述期望得到的結果/狀態。

~

❏ 推理型應用程式

我們可以將大多數的 SaaS 應用程式視為記錄系統,其功能可以分解為一系列推理任務。或許,我們可以將下一代面向使用者的應用程式,重建為一組推理基本元素之間的互動,如分類、摘要、文件處理、規劃和數據轉換等。

— 我稱這類新興的應用程式為推理應用程式。[3]

互動範式的改變會對我們每天都在接觸的應用帶來什麼樣的衝擊?《Reasoning apps: the next frontier for LLMs》一文引起了我的注意:

大部分 App 的 UI 設計,當中的每個操作都會對應到系統的某個狀態改變。也就是說,UI 的操作是 Imperative (命令式) 的,這對使用者有一定程度的認知要求 (例如: 往下捲動是更新、長按是複製、冗長的表單與下一步,等等…)。

如果今天請一個完全沒有使用過 App 的人來操作,他得重新學習這些 UI 元件如何對應到狀態的改變。我們並不是用天生的直覺在操作,那些習以為常的操作,只是被長期訓練後的結果。

現在,推理模型有機會翻轉這一切!推理模型的互動範式是 Declarative (宣告式) 的,當推理模型與 App 良好的整合,我們與 App 的互動是不是也應該是宣告式的呢?

只需要告訴 App 我們想要達成的目標/我們期望看到的結果,App 自己會 reasoning + retrieval,並配合 API 串接獨立行動。

旅遊型的 App 還需要機票、飯店、餐廳、景點分開規劃嗎?每個項目都要透過一層層的過濾選單,再耗費大量的時間去整合,才能找到適合自己的組合嗎?

電商購物、房屋租賃相關 App,還需要透過搜尋或是下拉選單來從茫茫大海中找到適合自己的物件嗎?

我們不再需要操作與狀態之間的映射,我們可以用更 “自然語言” 的方式與 app 互動。

如同前期《AI時代:洞察趨勢,引領組織與個人創新》當中提到:「AI 不是護城河,UX (Data) 才是」。

我預期,未來的創新,更多會發生在使用者體驗的層面。怎麼利用模型的推理能力,來顛覆過去操作狀態的 UI 慣性,在特定垂直領域做到進一步的簡化,相當令人期待。

~

❏ 智能詛咒

當模型學會推理之後,我們不再需要思維鏈 (Chain of Thought) 來引導模型思考,模型從副駕 (Copilot) 變成主駕,那 人類還剩下什麼價值?

當模型已能以系統一、系統二兩種模式運作以後,AI 仍然只是副駕駛的角色嗎?

給定目標,模型能從眾多策略組合當中客觀挑選出最佳的路徑,每個步驟還能挑選適合的知識與工具快速執行,我們似乎只剩下按下 Yes / No / Cancel 按鈕的功能。

推理型 LLM 的出現,加速了對 AGI 到來的那一天的想像。《The Intelligence Curse》[4] 揭露了我們應該要有的擔憂。

~

✔ AGI 更像是一種「資源」,而非「工具」

比起犁、蒸氣機或電腦,AGI 看起來更像煤或石油

需要花費巨大的財富來挖掘。

控制權只會集中在少數玩家 (公司或是國家)。

這些少數玩家主要從資源本身賺取利益,而非對人民的稅收或是人力資本產生的收益。

煤炭作為燃料取代了木材;AGI 做為文明的燃料,取代的將是我們。

我想這也是為什麼 DeepSeek (中國研發) 會引發如此關注的原因,背後牽扯的不僅是技術本身的超越,更多的是哪些強權能夠更快的掌握這項資源。

~

✔ 仰賴資源的國家

剛果民主共和國擁有價值超過 24 兆美元的未開採礦產。他們的國民過得如何?

剛果是世界上最貧窮的五個國家之一。 到 2024 年,估計 73.5% 的剛果人每天生活費不到 2.15 美元。 在 SSA 的極度貧困人口中,約有六分之一生活在剛果。

這是怎麼回事?數萬億的可用資源怎麼會導致赤貧?

經濟學家和政治學家稱之為資源詛咒。擁有豐富天然資源的國家,其經濟成長往往較差,貧窮率也較經濟多元的國家為高。

對少數玩家而言,靠 AGI 就能把事情做的又快又好又便宜的時候,投資人力相較於仰賴資源,顯得蒼白無力:

租賃國家 (如委內瑞拉、沙烏地阿拉伯) 依賴資源 (如石油) 而非人力資本來獲取收入,因此沒有動力投資於教育或基礎設施。

AGI 的普及 可能使整個社會陷入類似的「資源詛咒」,普通人將失去經濟價值,無法獲得投資或支援。

~

✔ 少數權力者的動機

我常聽到的反駁是,有些工作永遠無法自動化,因為我們會要求人類來做。

我經常聽到關於老師的反駁。我認為大多數家長都會強烈希望有一位真正的人類老師整天看著他們的孩子。

但這個論點完全忽略了更大的層面:並非沒有對教師的需求,而是沒有資助學校的誘因。

強大的權力者不會建造僱用人類或提供人類資源的東西,因為他們不需要這樣做。

國家和企業關心人們的原因在於:

人們提供稅收或利潤。

人們影響他們維持權力的能力 (如投票或威脅)。

當 AGI 取代人類勞動力後,這些誘因將消失,導致對人類的投資大幅減少。

~

✔ AGI 帶來的真正威脅

AGI 將使公司更傾向於裁員並停止招聘新人,因為人類勞動力不再具有經濟價值。

國家將削減公共資金,因為其收入來源將轉向 AI 公司而非普通公民。

普通人將失去經濟能力,難以滿足基本需求。

AI 安全社群專注於解決「意圖一致性」問題,但這並不意味著 AGI 會帶來烏托邦。

即使 AGI 被成功對齊 (不會產生不良意圖),智能詛咒仍可能導致資源分配不均和社會不平等 (可能產生不良意圖的是那些握有 AGI 的少數權力者)。

~

讀完《The Intelligence Curse》,原本對於 AGI 技術樂觀的立場,立即被蒙上一層陰影。在將 AI 技術活用到生活與工作中的同時,也應該站在社會與政策的層面上,多一些思考 🤔。

❏ 結語

「藍色監獄」的高中生們,從最初才能的原石,循著「利己主義」這個獎賞,一路打磨、碰撞,激盪出一支能夠快速應變且具有多元特色的勁旅。

繪心甚八 挑戰了東方民族固有的「利他主義」、「團隊優於個人」思維,在緊湊且高壓的環境之下,讓這群本具天賦的球員們,相信自己也能獨自綻放。

不同的獎賞催生出不同的動機,不同的動機造就不一樣的文化。

獎勵模型慢慢思考,催生了 OpenAI o1/o3, DeepSeek R1 等推理型 LLM,提升了 AI 面對複雜問題的能力。

當 AGI 逐漸成為少數玩家手上的資源時,人類又該如何設計適當的獎勵,避免落入「資源詛咒」之中。

回到開頭的那句引言:

“Show me the incentive, and I’ll show you the outcome.” – Charlie Munger

~

More ways I can help you 🚀

🦥 parting thoughts 🦥

強化學習是門博大精深的學問,想要了解更具體的細節,推薦李宏毅老師的課程。

~

如果這篇文章有幫助到你,記得按讚加分享 👍,請我喝杯咖啡 ☕,我們下期見!

🔖 參考資料

[1] Learning to reason with LLMs - https://openai.com/index/learning-to-reason-with-llms/

[2] Understanding and Effectively Using AI Reasoning Models -

[3] Reasoning apps: the next frontier for LLMs - https://kojo.blog/reasoning-apps/

[4] The Intelligence Curse - https://www.lesswrong.com/posts/Mak2kZuTq8Hpnqyzb/the-intelligence-curse